Neste artigo você encontrará:

Profissionais e empresas que trabalham com Big Data precisam recorrer a ferramentas para lidar com a grande quantidade de dados. Um poderoso mecanismo de processamento que é muito utilizado pelo mercado se chama Apache Spark, um framework de código aberto usado por grandes organizações e que se destaca por conta de sua velocidade, facilidade de uso e sofisticação.

Não é difícil imaginar uma arquitetura de Big Data que possa se beneficiar da utilização do Spark. O grande volume de dados pode estar associado ao tráfego de redes sociais, processamento de serviços de streaming, transferência de arquivos, classificação de dados e muitos outros cenários comuns.

Vamos entender o que é o Apache Spark e para que exatamente serve essa ferramenta.

Baixe o guia completo sobre

Big Data

O que é o Apache Spark?

O Apache Spark é uma poderosa ferramenta de Big Data que tem como objetivo processar grandes conjuntos de dados de forma distribuída e paralela. A solução foi originalmente desenvolvida na Universidade de Berkeley em 2009, e é 100% open source, hospedada no Apache Software Foundation e totalmente independente de fornecedores.

O Spark pode ser executado em conjunto com outras ferramentas de Big Data, como Hadoop, Mesos, Kubernetes ou até mesmo por conta própria através da nuvem com diversas fontes de dados.

Os principais diferenciais do Apache Spark são:

- Capacidade de processar dados em lote;

- Análise SQL dinâmica;

- Ciência de Dados em escala;

- Aprendizagem de máquina integrada.

Para que serve o Spark?

Um dos principais objetivos das empresas e profissionais que utilizam o Spark é aumentar a produtividade do desenvolvimento e criação do fluxo de trabalhos complexos. A estrutura de processamento paralelo dá suporte ao processamento na memória, aumentando a velocidade no desenvolvimento de aplicativos que analisando Big Data.

O Apache Spark suporta as seguintes linguagens de programação:

- Python

- Java

- .NET

- Scala

- SQL

- R

Embora esteja disponível para um grande número de linguagens de programação, a tecnologia R é a mais adaptada para trabalhar com o Apache Spark. Isso acontece por conta da possibilidade de diminuir significativamente o tamanho do código ao programar nessa linguagem.

Como funciona o Apache Spark?

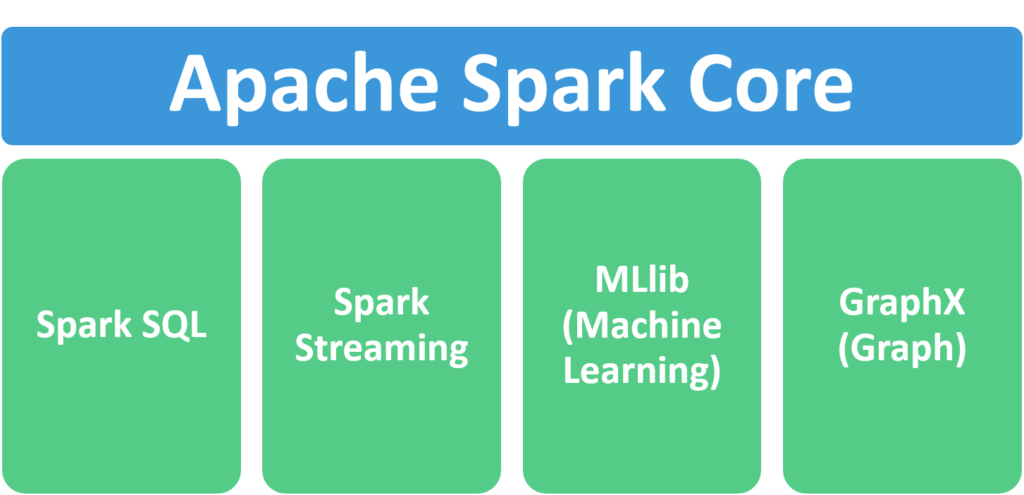

O Apache Spark conta com diversos componentes para diferentes tipos de processamento. Toda a estrutura é construída sobre o Spark Core, módulo que disponibiliza as funções básicas como as funções map, reduce, filter e collect.

- SparkSQL

Módulo do Spark que serve para trabalhar com dados estruturados e que oferece suporte a uma maneira convencional de acessar uma variedade de fontes de dados.

- Spark Streaming

Segmento do Spark Core que facilita a criação de soluções de streaming escalonáveis e tolerantes a falhas.

- MLlib

Essa é a biblioteca de Machine Learning (Aprendizado de Máquina) escalonável do Spark com ferramentas que tornam a ML prática, escalonável e fácil de implementar.

- GraphX

Esse módulo é utilizado para fazer processamento de computação paralela de imagens e outros elementos gráficos.

Por que Spark é bom para Big Data?

Essa é uma dúvida bastante comum. Afinal, por que escolher o Spark em vez de mecanismos que utilizam somente SQL?

Acontece que o Apache Spark é um mecanismo de computação de cluster muito eficiente para uso geral e que pode ser implementado de forma independente ou em um módulo Hadoop. Com a utilização desse framework, os desenvolvedores podem criar aplicativos de forma mais rápida nas diversas linguagens de programação suportadas.

Ao utilizar o Spark SQL, por exemplo, o programador pode conectar qualquer fonte de dados e apresentar como tabelas para diferentes clientes SQL disponíveis no mercado. Isso cria muita versatilidade para o desenvolvimento e eficiência para aplicações de Big Data.

Onde aprender mais

Se você ficou interessado nessa ferramenta de Big Data e quer aprender mais sobre como utilizá-la, a nossa recomendação é uma jornada de conhecimento estruturada. Nem sempre é fácil lidar com a fragmentação da informação disponível na internet e por isso os cursos específicos são ideais para o estudante.

O Instituto Infnet, referência na formação de profissionais técnicos, oferece alguns cursos ligados à Big Data e que utilizam as ferramentas mais modernas do mercado. Os cursos da instituição estão disponíveis para diversos níveis de conhecimento.